Evaluación

Aprenda a desarrollar una evaluación basada en la TdC

Elegir un diseño de evaluación adecuado

Una vez identificadas las preguntas, puede seleccionar un diseño de evaluación adecuado. El diseño de la evaluación se refiere al enfoque general de la recopilación de información o datos para responder a preguntas de investigación específicas.

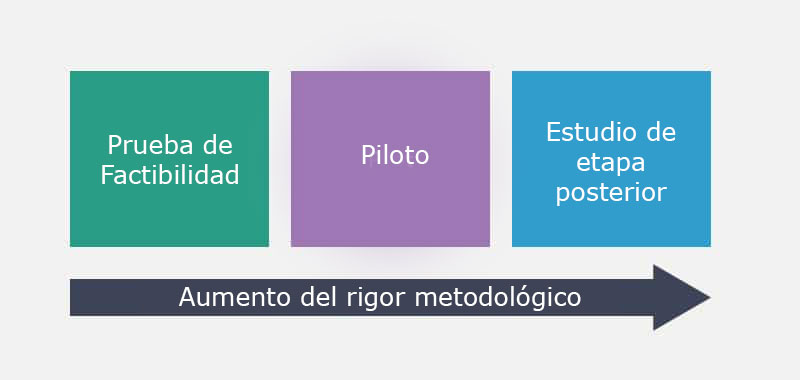

Existe una amplia gama de opciones de diseño de la investigación, que van desde los estudios de viabilidad a pequeña escala hasta los estudios a mayor escala que utilizan metodología científica avanzada. Cada opción de diseño es adecuada para responder a preguntas de investigación concretas.

El diseño adecuado para un proyecto específico depende de lo que el equipo del proyecto espere aprender de un ciclo concreto de ejecución y evaluación. Por lo general, a medida que los proyectos y programas pasan de pequeñas pruebas de viabilidad a estudios de fases posteriores, aumenta el rigor metodológico.

En otras palabras, utilizará herramientas y procesos más avanzados que le permitirán confiar más en sus resultados. El tamaño de las muestras es mayor, aumenta el número de herramientas de medición y las evaluaciones suelen estar estandarizadas y referidas a normas (diseñadas para comparar la puntuación de un individuo con la de una población específica).

En el marco IDEAS, la evaluación es un proceso continuo e iterativo. La idea es investigar la TdC de uno en uno, empezando por las estrategias del programa y ampliando gradualmente el enfoque hasta que esté listo para probar toda la teoría. Volviendo a la metáfora de la ficha de dominó, queremos ver si cada ficha de dominó de la cadena está cayendo del modo que esperamos.

Estudio de viabilidad

Empieza por preguntar:

"¿Son factibles y aceptables las estrategias del programa?".

Si está diseñando un programa desde cero y aplicándolo por primera vez, casi siempre tendrá que empezar por establecer la viabilidad y la aceptabilidad. Sin embargo, supongamos que lleva tiempo aplicando un programa, incluso sin una evaluación formal. En ese caso, es posible que ya haya establecido la viabilidad y la aceptabilidad simplemente demostrando que el programa es posible de aplicar y que los participantes consideran que es una buena opción. Si ese es el caso, tal vez puede saltarse este paso y centrar su atención en el impacto sobre los objetivos, que veremos con más detalle a continuación. Por otra parte, en el caso de un programa de larga duración que se adapta a un nuevo contexto o población, es posible que deba revisar su viabilidad y aceptabilidad.

El diseño de evaluación adecuado para responder a las preguntas sobre viabilidad y aceptabilidad suele ser un estudio de viabilidad con una muestra relativamente pequeña y un proceso simple de recopilación de datos.

En esta fase, se recopilarían datos sobre las estrategias del programa, incluyendo:

- Datos de fidelidad (¿se está aplicando el programa según lo previsto?)

- Opiniones de los participantes y del personal del programa (mediante encuestas, grupos de discusión y entrevistas).

- Información sobre reclutamiento y retención

- Datos demográficos de los participantes (para saber a quién se está sirviendo y si se está sirviendo a quien se pretendía servir).

Mediante los ciclos de iteración rápida, puede utilizar lo que aprenda de un estudio de viabilidad para mejorar las estrategias del programa.

Estudio piloto

Una vez que disponga de pruebas que sugieran que sus estrategias son viables y aceptables, puede dar el siguiente paso y centrar su atención en el impacto sobre los objetivos por preguntar:

"¿Hay evidencia que sugiera que los objetivos están cambiando en la dirección prevista?"

El diseño de evaluación adecuado para empezar a investigar el impacto sobre los objetivos suele ser un estudio piloto. Con una muestra algo mayor y un diseño más complejo, los estudios piloto suelen recopilar información de los participantes antes y después de participar en el programa. En esta fase, se recopilan datos sobre las estrategias y los objetivos del programa. Tenga en cuenta que en cada fase, el enfoque de su evaluación se amplía para incluir más ámbitos de su TdC. En un estudio piloto, además de los datos sobre los objetivos (su objetivo principal), querrá recopilar información sobre las estrategias para seguir analizando la viabilidad y la aceptabilidad.

En esta fase, se recopilarían datos sobre:

- Estrategias del programa

- Objetivos

Estudio en fase posterior

Una vez que haya establecido la viabilidad y la aceptabilidad y tenga evidencia que sugiera que sus objetivos están cambiando en la dirección esperada, estará listo para preguntar:

"¿Hay evidencia que respalde toda nuestra teoría del cambio?".

En otras palabras, se pregunta simultáneamente:

- ¿Siguen siendo viables y aceptables nuestras estrategias?

- ¿Cambian los objetivos en la dirección prevista?

- ¿Están cambiando los resultados en la dirección prevista?

- ¿Los moderadores ayudan a explicar la variabilidad en el impacto?

El diseño de evaluación adecuado para investigar toda su teoría del cambio es un estudio en una fase posterior, con una muestra más amplia y un diseño de estudio más sofisticado, que a menudo incluye algún tipo de grupo de control o comparación. En esta fase, se recopilarían datos sobre todos los ámbitos de la TdC: estrategias, objetivos, resultados y moderadores.

Preguntas frecuentes

Puede haber casos en los que tenga sentido saltarse los primeros pasos y pasar directamente a un estudio en una fase posterior. Pero en la mayoría de los casos, investigar la TdC dominio por dominio tiene varias ventajas. En primer lugar, los estudios posteriores suelen ser costosos en tiempo y dinero. Si se empieza con un estudio de viabilidad relativamente pequeño y de bajo coste y se avanza hacia una evaluación más rigurosa, se puede garantizar que el tiempo y el dinero se invierten en un programa que tiene más probabilidades de ser eficaz. Si se saltara a un estudio en una fase posterior, podría decepcionarse al descubrir que los resultados no cambian debido a problemas de viabilidad y aceptabilidad, o porque los objetivos no cambian (o no cambian lo suficiente).

Muchos programas recopilan datos sobre los resultados sin tener en cuenta las estrategias y los objetivos. Uno de los problemas de este enfoque es que si no se observan pruebas de impacto en los resultados del programa, no se podrá saber por qué. ¿Hubo un problema de viabilidad y las personas encargadas de ejecutar el programa no pudieron hacerlo como estaba previsto? ¿Hubo un problema de aceptabilidad, y los participantes tendieron a saltarse las sesiones o a abandonar el programa antes de tiempo? Tal vez la ejecución se desarrolló sin problemas, pero las estrategias no fueron eficaces para cambiar los objetivos, y ahí es donde se rompió la cadena causal. A menos que recopile datos sobre las estrategias y los objetivos, es difícil saber qué falló y qué puede hacer para mejorar la eficacia del programa.